多模态大语言模型在铁路行业应用探索

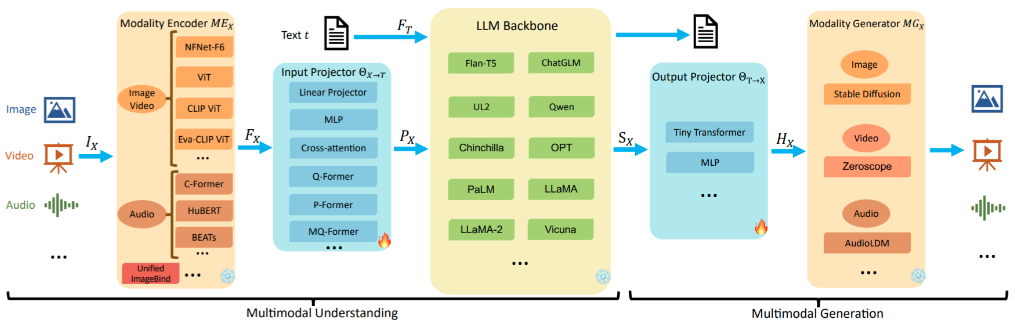

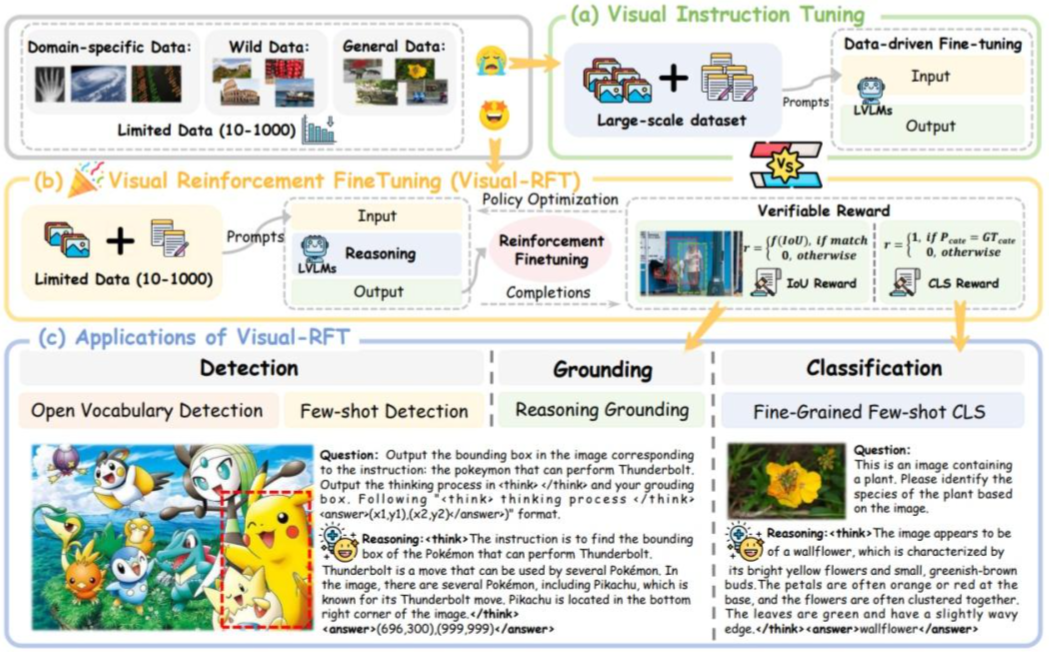

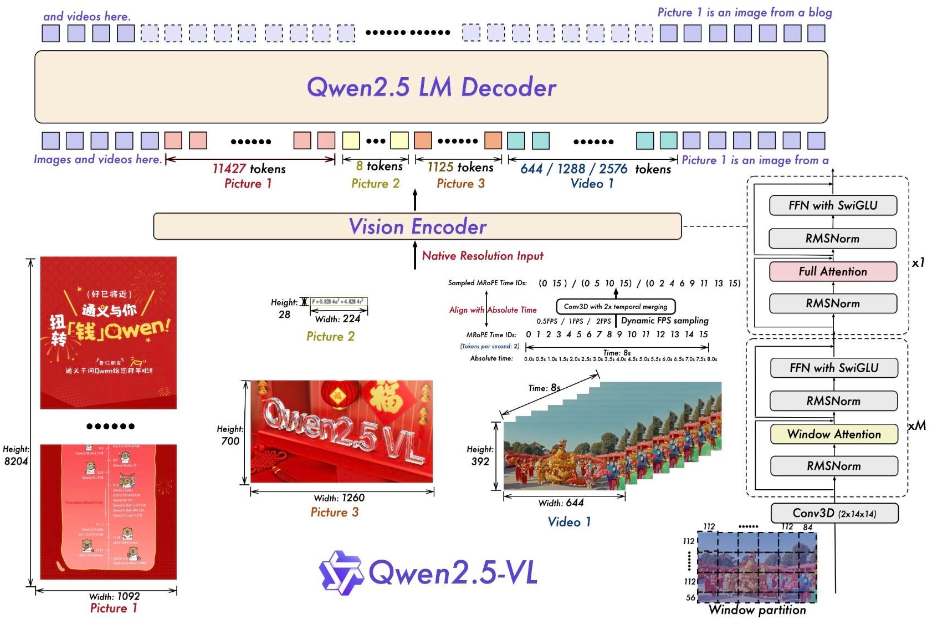

一、铁路行业多模态大语言模型应用面临的挑战 1、铁路行业数据特点 铁路行业涉及的数据模态丰富多样,每种模态都有其独特特点。 文本数据方面,包含大量专业的规章制度、技术手册、维修记录等,具有术语专业性强、逻辑结构严谨的特点。例如铁路信号设备维护手册,其中包含大量特定的信号术语和详细的操作流程描述,对模型理解和处理专业文本能力要求极高。 图像数据涵盖设备外观图像、轨道线路图像、作业现场图像和大量监控视频截图等。设备外观图像需模型准确识别设备部件状态、是否存在故障痕迹等;轨道线路图像要求模型能识别轨道几何形状、道岔状态等,图像数据具有分辨率高、细节特征复杂的特性。 语音数据主要为调度指挥语音、设备故障报警语音等,具有实时性强、语音质量受环境影响大的特点,如在嘈杂的车站环境中,调度语音可能存在噪声干扰,增加了语音识别和理解的难度。 2、铁路行业应用挑战 领域知识融合与专业性的要求。铁路行业涉及高度专业化的要求、规程(如信号系统逻辑、轨道工程标准),需将领域知识和专业知识有效嵌入模型训练和模型推理过程,避免生成错误或不符合规范的输出。 系统兼容性与既有设施改造。既有铁路系统(如传统信号设备、老旧传感器、传统架构信息化系统)可能无法直接支持AI模型的输入输出接口,需解决新旧系统兼容性问题,导致部署成本增加。 铁路运输生产过程人员协作与置信度。运输生产、运营维护过程中铁路对应专业人员(如调度员、维修工)对AI决策的接受度有限,需通过可解释性技术(如可视化推理路径)提升模型透明度,建立人机协同机制。 模型研发部署成本与应用的平衡。多模态大模型训练需要大规模算力支持,且铁路场景定制化开发成本高,面临模型研发部署成本与应用平衡的问题。 二、多模态大语言模型关键技术研究 针对铁路行业的特点、专业分工,多专业数据源特性及多模态大语言模型应用过程中面临的挑战,开展相关关键技术的研究工作。 1、多模态大语言模型定义 多模态大语言模型(MultiModal Large Language Models,简称MLLMs)是一类结合了大语言模型(Large Language Models,简称LLMs)的自然语言处理能力与对其他模态(如视觉、音频等)数据的理解与生成能力的模型。这些模型通过整合文本、图像、声音等多种类型的输入和输出,提供更加丰富和自然的交互体验。 2、多模态大语言模型架构 多模态模型架构包含5个部分,分别是:模态编码器(Modality Encoder)、输入映射器(Input Projector)、大模型骨干(LLM Backbone)、输出映射器(Output Projector)以及模态生成器(Modality Generator)[1]。模型架构如下图所示: 模态编码器:多模态大模型中的一个关键组件,它的主要任务是将不同模态的输入数据转换成模型能够进一步处理的特征表示。这些输入数据可以包括图像、文本、音频、视频等多种形式,而模态编码器的作用就像是翻译官,将这些不同语言(模态)的信息转换成一种共同的“语言”,以便模型能够理解和处理。 输入映射器:多模态大模型中的一种关键组件,它的主要作用是将不同模态的编码特征映射到一个共同的特征语义空间,以便这些特征可以被大型语言模型(LLM Backbone)统一处理和理解。 输出映射器:多模态大模型中的一种关键组件,它的主要任务是将大型语言模型(LLM)的输出信号映射回原始模态的空间,同时转换成适合不同模态生成器使用的特征表示。这些生成器可能是用于生成图像、视频、音频或其他模态的模型。 模态生成器:多模态大模型中的一种关键组件,它的主要作用是生成不同模态的输出,例如图像、视频或音频。使得模型能够灵活地处理和生成多种类型的数据,为用户提供更加丰富和自然的交互体验。 3、多模态大语言模型训练 多模态大模型的训练主要分为两个阶段:多模态预训练(MM PT, MultiModal Pre-Training)和多模态指令微调(MM IT, MultiModal Instruction Tuning)。 (1)多模态预训练,采用X−text数据集,输入和输出映射器用于实现不同模态之间的对齐。对于多模态理解模型,只优化文本生成损失;对于多模态生成模型,需要优化文本生成损失、模态生成损失和输出对齐损失。 (2)多模态指令微调,通过指令格式化的数据集对预训练的MLLMs进行微调,以提高模型遵循新指令的能力,增强其在未见任务上的性能。指令微调包括监督微调(SFT)和人类反馈强化学习(RLHF),增强多模态大模型的交互能力,显著改善零样本性能,极大增强泛化能力。 4、基于Visual-RFT的多模态大模型推理能力提升方法 开源 Visual-RFT,将RFT扩展到视觉任务,通过设计针对不同视觉任务的可验证奖励函数,提升多模态大模型在视觉感知和推理任务中的性能。Visual-RFT 的核心在于利用多模态大模型,生成多个包含推理过程和最终答案的响应,并通过可验证奖励函数对模型进行策略优化[2]。Visual-RFT 原理图,如下图所示: 奖励模型训练。给定问题和视觉图像输入后,策略模型会生成多个包含推理步骤的响应。然后,使用可验证奖励(如IoU奖励和分类奖励)与策略梯度优化算法来更新策略模型。可验证奖励函数包括: IoU奖励(目标检测):通过计算预测边界框与真实边界框的交并比(IoU)来评估检测任务的奖励。 分类准确率奖励(分类任务):通过比较模型输出类别与真实类别来评估奖励。 基于视觉强化微调(Visual-RFT)的能力特征,结合铁路行业的复杂环境要求,在细粒度图像分类、少样本目标检测、推理定位以及开放词汇目标检测基准测试中的实验结果表明,与监督微调(SFT)相比,Visual-RFT具有竞争力的性能和先进的泛化能力: 在大约100个样本的单样本细粒度图像分类中,Visual-RFT的准确率比基线提高了24.3%。 在少样本目标检测中,Visual-RFT在COCO的两样本设置中超过了基线21.9,在LVIS上超过了15.4。 Visual-RFT 减少了对人工标注的依赖,简化了奖励计算过程,并在多种视觉感知任务上取得了显著的性能提升。在细粒度分类、开放词汇检测、推理定位和少样本学习等任务中均优于监督微调方法,且在数据有限的情况下表现出强大的泛化能力。 三、Qwen2.5-VL-32B-Instruct大模型及铁路AI视频分析场景下模型能力测试验证 2025年3月24日,通义千问推出了Qwen2.5-VL系列大模型,获得了社区的广泛关注和积极反馈。在Qwen2.5-VL系列的基础上,使用强化学习持续优化模型,并使用 Apache 2.0协议开源32B参数规模的新VL模型-Qwen2.5-VL-32B-Instruct。本次推出的32B模型的核心特点如下: 多模态能力:支持视觉语言理解、图像细粒度解析(如交通指示牌分析)、视觉逻辑推理等任务,在复杂场景中表现优异。 数学推理突破:通过强化学习优化,显著提升复杂数学问题的求解准确性和分步推导能力,例如几何证明和多元函数优化。 本地部署优势:32B参数规模兼顾性能与效率,支持通过MLX框架在Apple Silicon设备本地运行,适合注重隐私的企业用户。 交互体验优化:输出风格更贴近人类偏好,回答更详细、格式规范,支持多轮深度对话。 Qwen2.5-VL中,模型的整体架构由三个主要组件构成:大型语言模型(LLM)、视觉编码器(Vision Encoder)和基于MLP的视觉-语言融合器[3],模型架构如下图所示: Qwen2.5-VL-32B 在强化学习框架下优化了主观体验和数学推理能力,下一步研究将聚焦于长且有效的推理过程[4],以突破视觉模型在处理高度复杂、多步骤视觉推理任务中的边界。 通义千问官方未明确本地化部署Qwen2.5-VL-32B-Instruct模型的硬件最低配置,但基于32B参数规模推测,需较高内存(建议至少32GB以上)及支持大规模计算的GPU芯片。综合数据量、样本数量、并发量和吞吐量的核心关键要素,本次本地化部署选取硅基流动一体机,完成铁路AI视频分析场景Qwen2.5-VL-32模型能力测试验证。实验室模型能力测试验证信息统计如下表所示[5]: 模型能力测试验证结论: (1)本次实验室模型能力测试验证,基于本地化部署的Qwen2.5-VL-32B大模型,共计测试验证铁路AI视频分析场景16个。 (2)在接触网异物、烟火识别、室内打电话/玩手机、室外打电话/玩手机、睡觉判断、塌陷检测、防护网开口、铁路入侵异物检测这8个场景中,Qwen2.5-VL-32B多模态大模型的正检率均超过70%。但是在另外8个场景中,Qwen2.5-VL-32B多模态大模型存在较多漏检、误检以及思考过程与输出结果不相符的情况。 (3)原始的Qwen2.5-VL-32B多模态大模型不适合直接用于有数据量基础的检测场景。在铁路行业有数据基础的场景中,基于有监督训练小模型的检出能力比多模态大模型强。在没有数据基础的场景中,可以基于多模态大模型进行初步分析,后基于过滤策略及复核策略进行输出结果的筛选。 (4)在铁路行业AI视频分析场景下,可以尝试基于多模态大模型进行微调和重新训练,使其更好地适应铁路场景的需求。 参考文献: [1] https://qianfan.cloud.baidu.com/qianfandev/topic/374006 [2] https://arxiv.org/pdf/2308.01825 [3] https://qwenlm.github.io/zh/blog/qwen2.5-vl-32b/ [4] https://arxiv.org/abs/2502.13923 [5] 人工智能视觉大模型在铁路线路异物入侵场景中的应用

-

2021大数据“星河”璀璨,“铁路数据仓库和数据治理平台”榜上有名

2022-05-17 -

安全可信 智胜云端—— 佳讯飞鸿荣获“可信云”权威认证

2022-05-17 -

护航冬奥、保障京张 佳讯飞鸿科技助力“中国加速度”

2022-05-17 -

云领未来!佳讯飞鸿携手华为发布铁路物联网解决方案

2022-05-17 -

佳讯飞鸿参与京广铁路塌方线路抢险

2021-02-08 -

5G创新再获殊荣,佳讯飞鸿智慧赋能城市建设

2022-02-08 -

佳讯飞鸿智慧赋能中老铁路 续写“中国铁路出海”新篇章

2022-05-17 -

《智能铁路通信云技术白皮书(2020)》和《铁路下一代承载网应用技术白皮书(2020)》隆重发布

2022-02-08 -

两会之声 | 钟章队委员:补齐轨道交通新基建短板 建成高质量综合轨交网络

2022-02-08 -

佳讯飞鸿与中国移动积极构建5G行业专网生态 赋能5G行业专网技术演进

2022-02-08